AdaBoost--从原理到实现

一.引入

对于Adaboost,可以说是久闻大名,据说在Deep Learning出来之前,SVM和Adaboost是效果最好的 两个算法,而Adaboost是提升树(boosting tree),所谓“提升树”就是把“弱学习算法”提升(boost)为“强学习算法”(语自《统计学习方法》),而其中最具代表性的也就是Adaboost了,貌似Adaboost的结构还和Neural Network有几分神似,我倒没有深究过,不知道是不是有什么干货

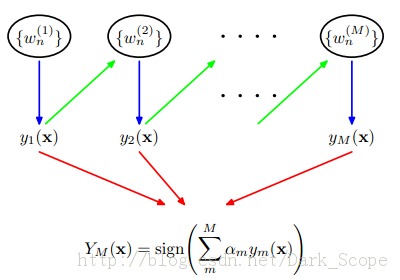

(from PRML)

(from PRML)

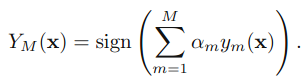

这就是Adaboost的结构,最后的分类器YM是由数个弱分类器(weak classifier)组合而成的,相当于最后m个弱分类器来投票决定分类,而且每个弱分类器的“话语权”α不一样。

这里阐述下算法的具体过程:

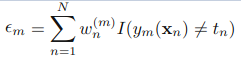

1.初始化所有训练样例的权重为1 / N,其中N是样例数 2.for m=1,……M:a).训练弱分类器ym(),使其最小化权重误差函数(weighted error function):

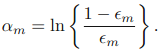

b)接下来计算该弱分类器的话语权α:

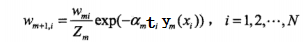

c)更新权重:

其中Zm:

是规范化因子,使所有w的和为1。(这里公式稍微有点乱)

3.得到最后的分类器:

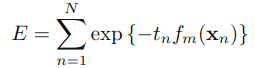

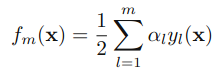

其中 fm是前m个分类器的结合

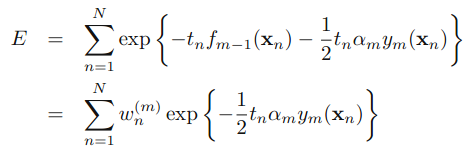

其中 fm是前m个分类器的结合  此时我们要最小化E,同时要考虑α和yl, 但现在我们假设前m-1个α和y都已经fixed了:那么

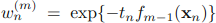

此时我们要最小化E,同时要考虑α和yl, 但现在我们假设前m-1个α和y都已经fixed了:那么  其中

其中 ,可以被看做一个常量,因为它里面没有αm和ym: 接下来:

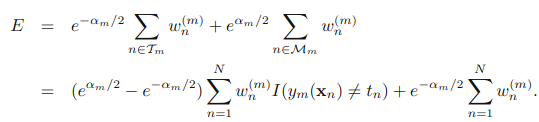

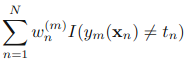

,可以被看做一个常量,因为它里面没有αm和ym: 接下来:  其中Tm表示正分类的集合,Mm表示误分类的集合,这一步其实就是把上面那个式子拆开,没什么复杂的东西 然后就是找ym了,就是最小化下式的过程,其实就是我们训练弱分类器

其中Tm表示正分类的集合,Mm表示误分类的集合,这一步其实就是把上面那个式子拆开,没什么复杂的东西 然后就是找ym了,就是最小化下式的过程,其实就是我们训练弱分类器  有了ym,α也就可以找了,然后继续就可以找到更新w的公式了(注意这里得到的w公式是没有加规范化因子Z的公式,为了计算方便我们加了个Z进去) 因为这里算出来直接就是上面过程里的公式,就不再赘述了,有兴趣你可以自己算一算

有了ym,α也就可以找了,然后继续就可以找到更新w的公式了(注意这里得到的w公式是没有加规范化因子Z的公式,为了计算方便我们加了个Z进去) 因为这里算出来直接就是上面过程里的公式,就不再赘述了,有兴趣你可以自己算一算  )

)

可以看到也是三个分类器就没有误分点了,权值的选择也是差不多的其中后面那个-1 表示大于threshold分为负类,小于分为正类。1则相反

加一些其它数据试试:

结果:我们把图画出来就是:

基本还是正确的,这是四个子分类器的图,不是最后总分类器的图啊~~~(实验的代码你也可以在DML里面找到,你都看到这了,给个star好不好~~~~~)

Reference: 【1】 《Pattern Recognition And Machine Learning》 【2】 《统计学习方法》