再谈应用环境下的TIME_WAIT和CLOSE_WAIT?昨天解决了一个HttpClient调用错误导致的服务器异常,具体过程如下

再谈应用环境下的TIME_WAIT和CLOSE_WAIT

?

昨天解决了一个HttpClient调用错误导致的服务器异常,具体过程如下:

http://blog.csdn.net/shootyou/article/details/6615051

里头的分析过程有提到,通过查看服务器网络状态检测到服务器有大量的CLOSE_WAIT的状态。

?

在服务器的日常维护过程中,会经常用到下面的命令:

?

Plain代码?

- netstat?-n?|?awk?'/^tcp/?{++S[$NF]}?END?{for(a?in?S)?print?a,?S[a]}'????

它会显示例如下面的信息:

TIME_WAIT 814

CLOSE_WAIT 1

FIN_WAIT1 1

ESTABLISHED 634

SYN_RECV 2

LAST_ACK 1

常用的三个状态是:ESTABLISHED 表示正在通信,TIME_WAIT 表示主动关闭,CLOSE_WAIT 表示被动关闭。

?

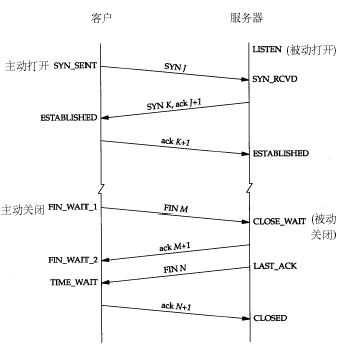

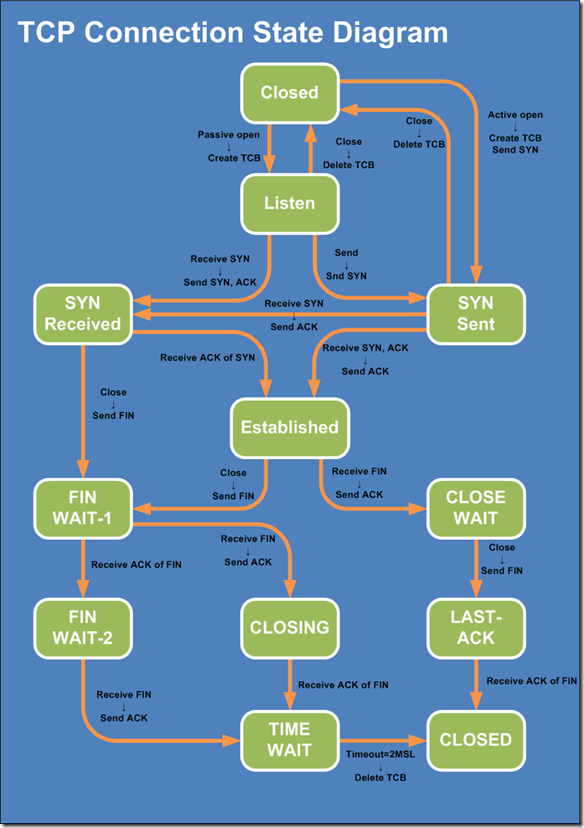

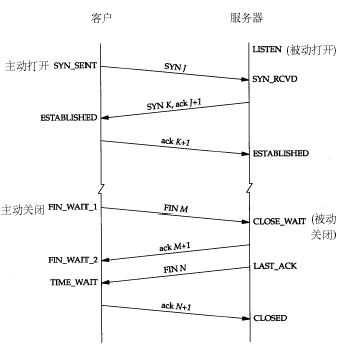

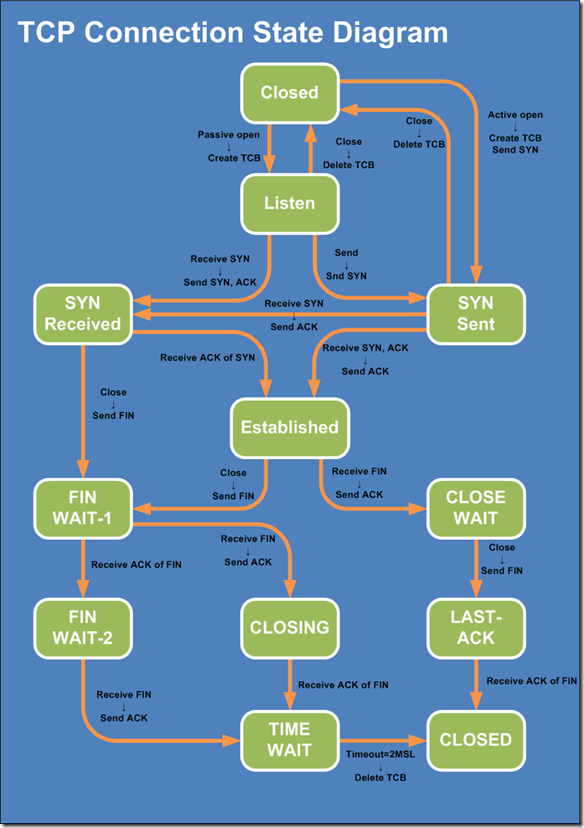

具体每种状态什么意思,其实无需多说,看看下面这种图就明白了,注意这里提到的服务器应该是业务请求接受处理的一方:

?

Plain代码?

- MSL为一个TCP Segment (某一块TCP ??网路封包)从来源送到目的之间可续存的时间(也就是一个网路封包在网路上传输时能存活的时间),由于RFC??793??TCP传输协定是在??1981??年定义的,当时 ??的网路速度不像现在的网际网路那样发达,你可以想像你从浏览器输入网址等到第一个byte出现要等??4??分钟吗?在现在的网路环境下几乎不可能有这种事情发生,因此我们大可将TIME_WAIT状态的续存时间大幅调低,好让连线埠(Ports)能更快空出来给其他连线使用。 ?

?

再引用网络资源的一段话:

Plain代码?

- 值得一说的是,对于基于TCP的HTTP协议,关闭TCP连接的是Server端,这样,Server端会进入TIME_WAIT状态,可?想而知,对于访问量大的Web?Server,会存在大量的TIME_WAIT状态,假如server一秒钟接收1000个请求,那么就会积压240*1000=240,000个?TIME_WAIT的记录,维护这些状态给Server带来负担。当然现代操作系统都会用快速的查找算法来管理这些TIME_WAIT,所以对于新的?TCP连接请求,判断是否hit中一个TIME_WAIT不会太费时间,但是有这么多状态要维护总是不好。??

- HTTP协议1.1版规定default行为是Keep-Alive,也就是会重用TCP连接传输多个?request/response,一个主要原因就是发现了这个问题。??

也就是说HTTP的交互跟上面画的那个图是不一样的,关闭连接的不是客户端,而是服务器,所以web服务器也是会出现大量的TIME_WAIT的情况的。

现在来说如何来解决这个问题。

解决思路很简单,就是让服务器能够快速回收和重用那些TIME_WAIT的资源。

下面来看一下我们网管对/etc/sysctl.conf文件的修改:Plain代码?

- #对于一个新建连接,内核要发送多少个?SYN?连接请求才决定放弃,不应该大于255,默认值是5,对应于180秒左右时间???

- net.ipv4.tcp_syn_retries=2??

- #net.ipv4.tcp_synack_retries=2??

- #表示当keepalive起用的时候,TCP发送keepalive消息的频度。缺省是2小时,改为300秒??

- net.ipv4.tcp_keepalive_time=1200??

- net.ipv4.tcp_orphan_retries=3??

- #表示如果套接字由本端要求关闭,这个参数决定了它保持在FIN-WAIT-2状态的时间??

- net.ipv4.tcp_fin_timeout=30???

- #表示SYN队列的长度,默认为1024,加大队列长度为8192,可以容纳更多等待连接的网络连接数。??

- net.ipv4.tcp_max_syn_backlog?=?4096??

- #表示开启SYN?Cookies。当出现SYN等待队列溢出时,启用cookies来处理,可防范少量SYN攻击,默认为0,表示关闭??

- net.ipv4.tcp_syncookies?=?1??

- #表示开启重用。允许将TIME-WAIT?sockets重新用于新的TCP连接,默认为0,表示关闭??

- net.ipv4.tcp_tw_reuse?=?1??

- #表示开启TCP连接中TIME-WAIT?sockets的快速回收,默认为0,表示关闭??

- net.ipv4.tcp_tw_recycle?=?1??

- ##减少超时前的探测次数??

- net.ipv4.tcp_keepalive_probes=5??

- ##优化网络设备接收队列??

- net.core.netdev_max_backlog=3000??

Plain代码??

- ??

修改完之后执行/sbin/sysctl -p让参数生效。

这里头主要注意到的是net.ipv4.tcp_tw_reuse net.ipv4.tcp_tw_recycle

net.ipv4.tcp_fin_timeout

net.ipv4.tcp_keepalive_*

这几个参数。

net.ipv4.tcp_tw_reuse和net.ipv4.tcp_tw_recycle的开启都是为了回收处于TIME_WAIT状态的资源。

net.ipv4.tcp_fin_timeout这个时间可以减少在异常情况下服务器从FIN-WAIT-2转到TIME_WAIT的时间。

net.ipv4.tcp_keepalive_*一系列参数,是用来设置服务器检测连接存活的相关配置。

关于keepalive的用途可以参考:http://hi.baidu.com/tantea/blog/item/580b9d0218f981793812bb7b.html

2.服务器保持了大量CLOSE_WAIT状态休息一下,喘口气,一开始只是打算说说TIME_WAIT和CLOSE_WAIT的区别,没想到越挖越深,这也是写博客总结的好处,总可以有意外的收获。

TIME_WAIT状态可以通过优化服务器参数得到解决,因为发生TIME_WAIT的情况是服务器自己可控的,要么就是对方连接的异常,要么就是自己没有迅速回收资源,总之不是由于自己程序错误导致的。但是CLOSE_WAIT就不一样了,从上面的图可以看出来,如果一直保持在CLOSE_WAIT状态,那么只有一种情况,就是在对方关闭连接之后服务器程序自己没有进一步发出ack信号。换句话说,就是在对方连接关闭之后,程序里没有检测到,或者程序压根就忘记了这个时候需要关闭连接,于是这个资源就一直被程序占着。个人觉得这种情况,通过服务器内核参数也没办法解决,服务器对于程序抢占的资源没有主动回收的权利,除非终止程序运行。

如果你使用的是HttpClient并且你遇到了大量CLOSE_WAIT的情况,那么这篇日志也许对你有用:http://blog.csdn.net/shootyou/article/details/6615051在那边日志里头我举了个场景,来说明CLOSE_WAIT和TIME_WAIT的区别,这里重新描述一下:服务器A是一台爬虫服务器,它使用简单的HttpClient去请求资源服务器B上面的apache获取文件资源,正常情况下,如果请求成功,那么在抓取完资源后,服务器A会主动发出关闭连接的请求,这个时候就是主动关闭连接,服务器A的连接状态我们可以看到是TIME_WAIT。如果一旦发生异常呢?假设请求的资源服务器B上并不存在,那么这个时候就会由服务器B发出关闭连接的请求,服务器A就是被动的关闭了连接,如果服务器A被动关闭连接之后程序员忘了让HttpClient释放连接,那就会造成CLOSE_WAIT的状态了。

所以如果将大量CLOSE_WAIT的解决办法总结为一句话那就是:查代码。因为问题出在服务器程序里头啊。

参考资料:1.windows下的TIME_WAIT的处理可以参加这位大侠的日志:http://blog.miniasp.com/post/2010/11/17/How-to-deal-with-TIME_WAIT-problem-under-Windows.aspx

2.WebSphere的服务器优化有一定参考价值:http://publib.boulder.ibm.com/infocenter/wasinfo/v6r0/index.jsp?topic=/com.ibm.websphere.express.doc/info/exp/ae/tprf_tunelinux.html3.各种内核参数的含义:http://haka.sharera.com/blog/BlogTopic/32309.htm4.linux服务器历险之sysctl优化linux网络:http://blog.csdn.net/chinalinuxzend/article/details/1792184